本文内容来源于以下两篇文章:

一、 基于单Redis节点的分布式锁

获取锁:

1 | SET resource_name my_random_value NX PX 30000 |

- my_random_value是由客户端生成的一个随机字符串,它要保证在足够长的一段时间内在所有客户端的所有获取锁的请求中都是唯一的

- NX表示只有当resource_name对应的key值不存在的时候才能SET成功。这保证了只有第一个请求的客户端才能获得锁,而其它客户端在锁被释放之前都无法获得锁

- PX 30000表示这个锁有一个30秒的自动过期时间

释放锁:

执行以下Redis Lua脚本:

1 | if redis.call("get",KEYS[1]) == ARGV[1] then |

重点:

- 必须要设置一个过期时间。防止客户端获取锁后崩溃导致一直持有该锁

- 获取锁时保证原子性

- 获取锁时必须设置一个随机字符串my_random_value,保证了客户端释放的锁必须是自己持有的那个锁

- 释放锁的操作必须使用Lua脚本来实现,保证原子性

问题:

【1】当客户端获取锁后,此时Redis Master节点宕机,系统触发failover自动切换到Slave节点,但由于Redis的主从复制是异步的,这可能导致在failover过程中丧失锁的安全性。考虑下面的执行序列:

- 客户端1从Master获取了锁

- Master宕机了,存储锁的key还没有来得及同步到Slave上

- Slave升级为Master

- 客户端2从新的Master获取到了对应同一个资源的锁

【2】过期时间设置多长才合适。如果设置太短的话,锁就有可能在客户端完成对于共享资源的访问之前过期,从而失去保护;如果设置太长的话,一旦某个持有锁的客户端释放锁失败,那么就会导致所有其它客户端都无法获取锁,从而长时间内无法正常工作

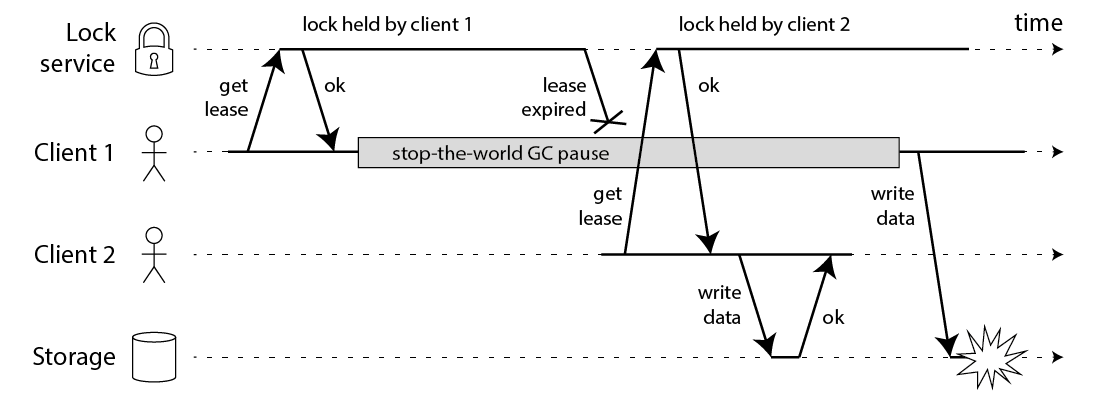

【3】如果持有锁的客户端长期阻塞导致锁过期(如发生Full GC),共享资源是不是已经失去了保护,如图

二、 分布式锁Redlock

分布式锁的算法Redlock,它基于N个完全独立的Redis节点(通常情况下N可以设置成5)

获取锁:

获取当前时间(毫秒数)

按顺序依次向N个Redis节点执行获取锁的操作。这个获取操作跟前面基于单Redis节点的获取锁的过程相同,包含随机字符串

my_random_value,也包含过期时间(比如PX 30000,即锁的有效时间)。为了保证在某个Redis节点不可用的时候算法能够继续运行,这个获取锁的操作还有一个超时时间(time out),它要远小于锁的有效时间(几十毫秒量级)。客户端在向某个Redis节点获取锁失败以后,应该立即尝试下一个Redis节点。这里的失败,应该包含任何类型的失败,比如该Redis节点不可用,或者该Redis节点上的锁已经被其它客户端持有(注:Redlock原文中这里只提到了Redis节点不可用的情况,但也应该包含其它的失败情况)计算整个获取锁的过程总共消耗了多长时间,计算方法是用当前时间减去第1步记录的时间。如果客户端从大多数Redis节点(>= N/2+1)成功获取到了锁,并且获取锁总共消耗的时间没有超过锁的有效时间(lock validity time),那么这时客户端才认为最终获取锁成功;否则,认为最终获取锁失败

如果最终获取锁成功了,那么这个锁的有效时间应该重新计算,它等于最初的锁的有效时间减去第3步计算出来的获取锁消耗的时间

如果最终获取锁失败了(可能由于获取到锁的Redis节点个数少于N/2+1,或者整个获取锁的过程消耗的时间超过了锁的最初有效时间),那么客户端应该立即向所有Redis节点发起释放锁的操作(即前面介绍的Redis Lua脚本)

释放锁:

客户端向所有Redis节点发起释放锁的操作,不管这些节点当时在获取锁的时候成功与否

重点:

- 在最后释放锁的时候,antirez在算法描述中特别强调,客户端应该向所有Redis节点发起释放锁的操作。因为,客户端发给某个Redis节点的获取锁的请求成功到达了该Redis节点,这个节点也成功执行了

SET操作,但是它返回给客户端的响应包却丢失了。这在客户端看来,获取锁的请求由于超时而失败了,但在Redis这边看来,加锁已经成功了。所以,释放锁的时候,客户端也应该对当时获取锁失败的那些Redis节点同样发起请求

问题:

【4】如果有节点发生崩溃重启,还是会对锁的安全性有影响的。具体的影响程度跟Redis对数据的持久化程度有关。假设一共有5个Redis节点:A, B, C, D, E。设想发生了如下的事件序列:

- 客户端1成功锁住了A, B, C,获取锁成功(但D和E没有锁住)

- 节点C崩溃重启了,但客户端1在C上加的锁没有持久化下来,丢失了

- 节点C重启后,客户端2锁住了C, D, E,获取锁成功

- 这样,客户端1和客户端2同时获得了锁(针对同一资源)

【5】由于Redlock本质上是建立在一个同步模型之上,对系统的记时假设(timing assumption)有很强的要求,因此本身的安全性是不够的

解决方案:

【1】由于N个Redis节点中的大多数能正常工作就能保证Redlock正常工作,因此理论上它的可用性更高,单Redis节点的分布式锁在failover的时候锁失效的问题,在Redlock中不存在了

【3】释放锁时会检查my_random_value,若不一致出现释放锁失败,客户端应该回滚事务

【4】延迟重启(delayed restarts)的概念。也就是说,一个节点崩溃后,先不立即重启它,而是等待一段时间再重启,这段时间应该大于锁的有效时间(lock validity time)。这样的话,这个节点在重启前所参与的锁都会过期,它在重启后就不会对现有的锁造成影响

【5】有争议,antirez认为在实际系统中是可以避免大的时钟跳跃的。当然,这取决于基础设施和运维方式

三、 基于ZooKeeper的分布式锁

- 客户端尝试创建一个znode节点,比如

/lock。那么第一个客户端就创建成功了,相当于拿到了锁;而其它的客户端会创建失败(znode已存在),获取锁失败。 - 持有锁的客户端访问共享资源完成后,将znode删掉,这样其它客户端接下来就能来获取锁了。

- znode应该被创建成ephemeral的。这是znode的一个特性,它保证如果创建znode的那个客户端崩溃了,那么相应的znode会被自动删除。这保证了锁一定会被释放。

看起来这个锁相当完美,没有Redlock过期时间的问题,而且能在需要的时候让锁自动释放。但仔细考察的话,并不尽然。

ZooKeeper是怎么检测出某个客户端已经崩溃了呢?实际上,每个客户端都与ZooKeeper的某台服务器维护着一个Session,这个Session依赖定期的心跳(heartbeat)来维持。如果ZooKeeper长时间收不到客户端的心跳(这个时间称为Sesion的过期时间),那么它就认为Session过期了,通过这个Session所创建的所有的ephemeral类型的znode节点都会被自动删除。

设想如下的执行序列:

- 客户端1创建了znode节点

/lock,获得了锁。 - 客户端1进入了长时间的GC pause。

- 客户端1连接到ZooKeeper的Session过期了。znode节点

/lock被自动删除。 - 客户端2创建了znode节点

/lock,从而获得了锁。 - 客户端1从GC pause中恢复过来,它仍然认为自己持有锁。

最后,客户端1和客户端2都认为自己持有了锁,冲突了。这与之前Martin在文章中描述的由于GC pause导致的分布式锁失效的情况类似。

看起来,用ZooKeeper实现的分布式锁也不一定就是安全的。该有的问题它还是有。但是,ZooKeeper作为一个专门为分布式应用提供方案的框架,它提供了一些非常好的特性,是Redis之类的方案所没有的。像前面提到的ephemeral类型的znode自动删除的功能就是一个例子。

还有一个很有用的特性是ZooKeeper的watch机制。这个机制可以这样来使用,比如当客户端试图创建/lock的时候,发现它已经存在了,这时候创建失败,但客户端不一定就此对外宣告获取锁失败。客户端可以进入一种等待状态,等待当/lock节点被删除的时候,ZooKeeper通过watch机制通知它,这样它就可以继续完成创建操作(获取锁)。这可以让分布式锁在客户端用起来就像一个本地的锁一样:加锁失败就阻塞住,直到获取到锁为止。这样的特性Redlock就无法实现。

小结一下,基于ZooKeeper的锁和基于Redis的锁相比在实现特性上有两个不同:

- 在正常情况下,客户端可以持有锁任意长的时间,这可以确保它做完所有需要的资源访问操作之后再释放锁。这避免了基于Redis的锁对于有效时间(lock validity time)到底设置多长的两难问题。实际上,基于ZooKeeper的锁是依靠Session(心跳)来维持锁的持有状态的,而Redis不支持Sesion。

- 基于ZooKeeper的锁支持在获取锁失败之后等待锁重新释放的事件。这让客户端对锁的使用更加灵活。